Application

Une application fil rouge pour illustrer l’intérêt d’appliquer graduellement les bonnes pratiques dans une optique de mise en production d’une application de data science.

Introduction

L’objectif de cette mise en application est d’illustrer les différentes étapes qui séparent la phase de développement d’un projet de celle de la mise en production. Elle permettra de mettre en pratique les différents concepts présentés tout au long du cours.

L’objectif pédagogique principal de cette application est d’adopter un point de vue pragmatique en choisissant des outils et des méthodes de travail qui permettent de réaliser des objectifs ambitieux de valorisation de données. Python sera le trait d’union entre les différentes technologies ou infrastructures que nous utiliserons.

Cette application est un tutoriel pas à pas pour avoir un projet reproductible et disponible sous plusieurs livrables. Toutes les étapes ne sont pas indispensables à tous les projets de data science et il existe des outils alternatifs à ceux présentés. Néanmoins, les outils présentés ont l’avantage d’être très bien intégrés à Python, bien configurés si vous utilisez le SSPCloud comme nous le recommandons, tout en étant agnostiques sur le reste des outils que vous utilisez ; de sorte à ne pas être bloquants si on remplace l’une des briques logicielles par une autre.

Nous nous plaçons dans une situation initiale correspondant à la fin de la phase de développement d’un projet de data science. On a un notebook un peu monolithique, qui réalise les étapes classiques d’un pipeline de machine learning :

- Import de données ;

- Statistiques descriptives et visualisations ;

- Feature engineering ;

- Entraînement d’un modèle ;

- Evaluation du modèle.

Objectif

L’objectif est d’améliorer le projet de manière incrémentale jusqu’à pouvoir le mettre en production, en le valorisant sous une forme adaptée et en adoptant une méthode de travail fluidifiant les évolutions futures.

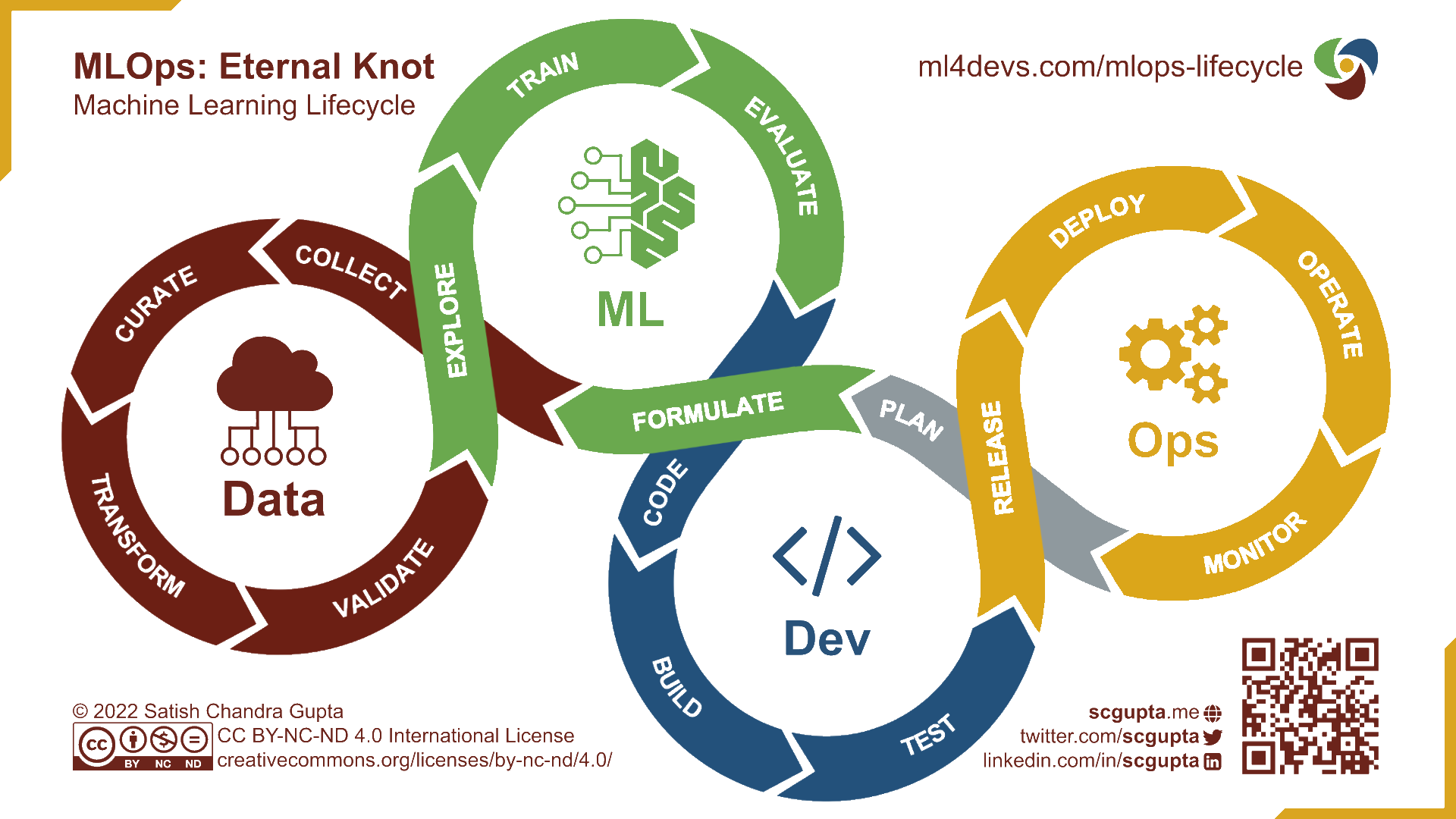

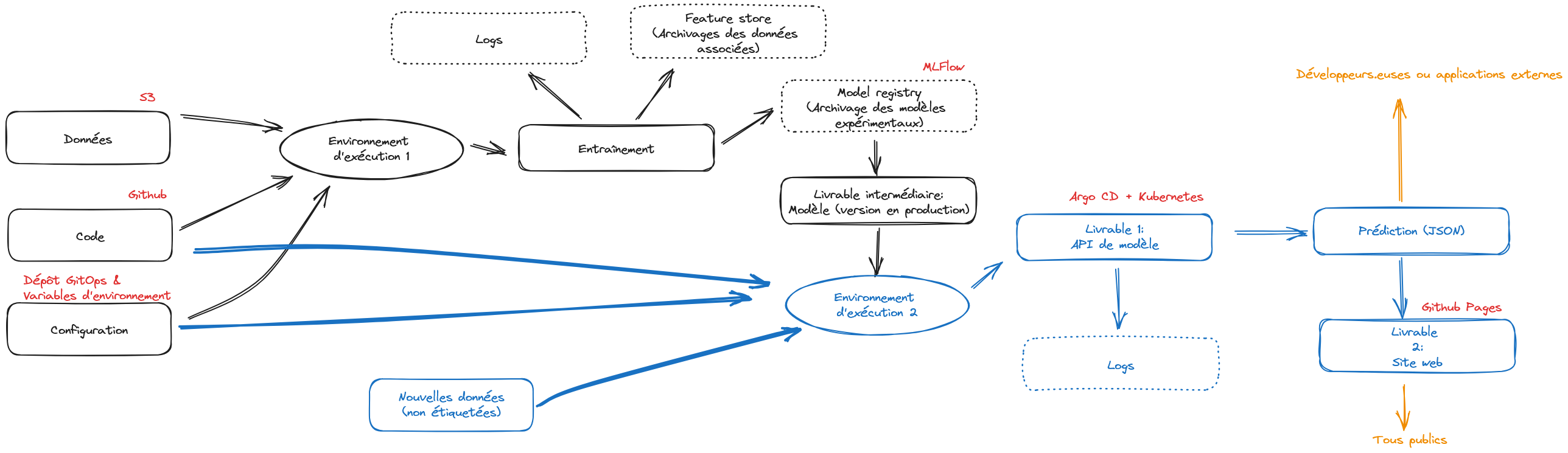

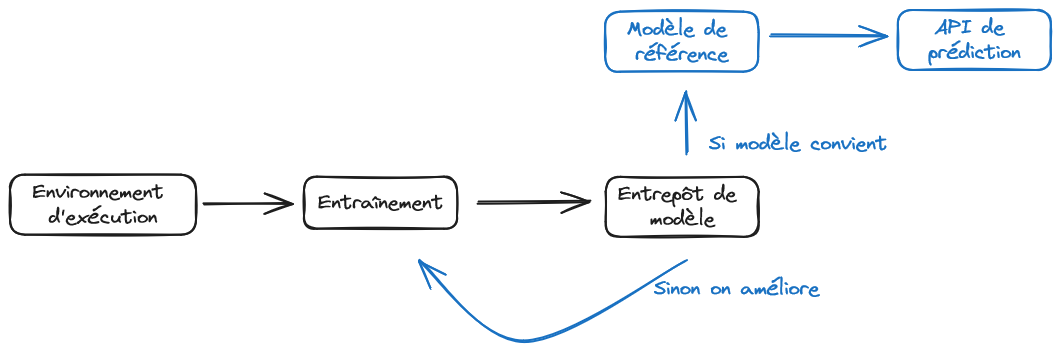

En améliorant et enrichissant progressivement notre projet, nous aboutirons sur le cercle infini du MLOps (Figure 1) permettant la coexistence de versions en production et en développement

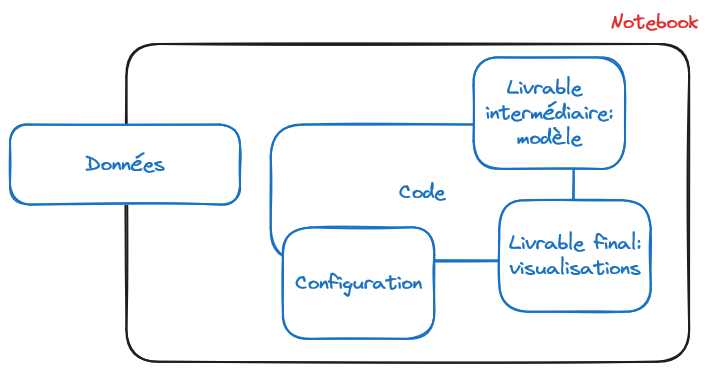

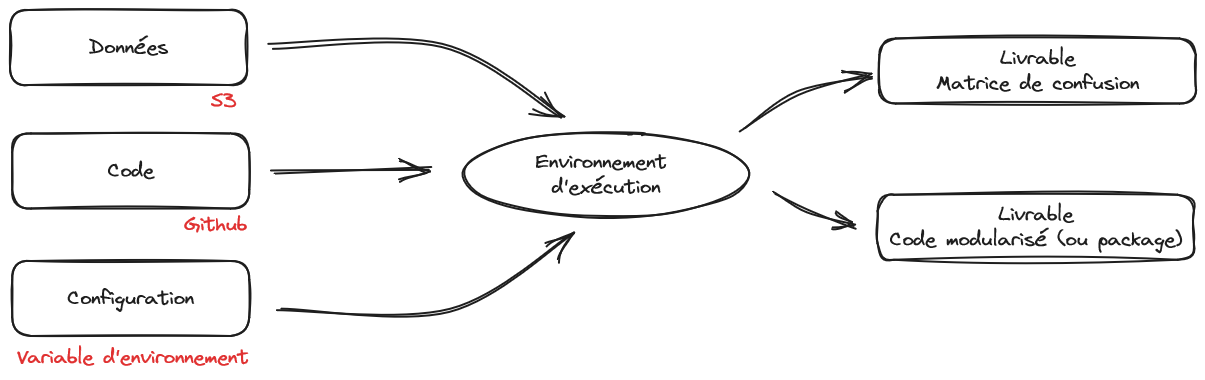

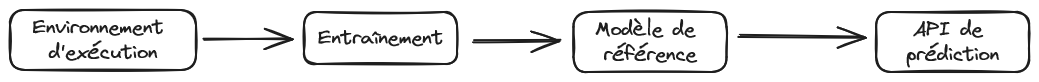

La Figure 2 montre que notre point de départ initial, à savoir un notebook, mélange tout. Ceci rend très complexe la mise à jour de notre modèle ou l’exploitation de notre modèle sur de nouvelles données, ce qui est pourtant la raison d’être du machine learning qui est pensé pour l’extrapolation. Si on vous demande de valoriser votre modèle sur de nouvelles données, vous risquez de devoir refaire tourner tout votre notebook, avec le risque de ne pas retrouver les mêmes résultats que dans la version précédente.

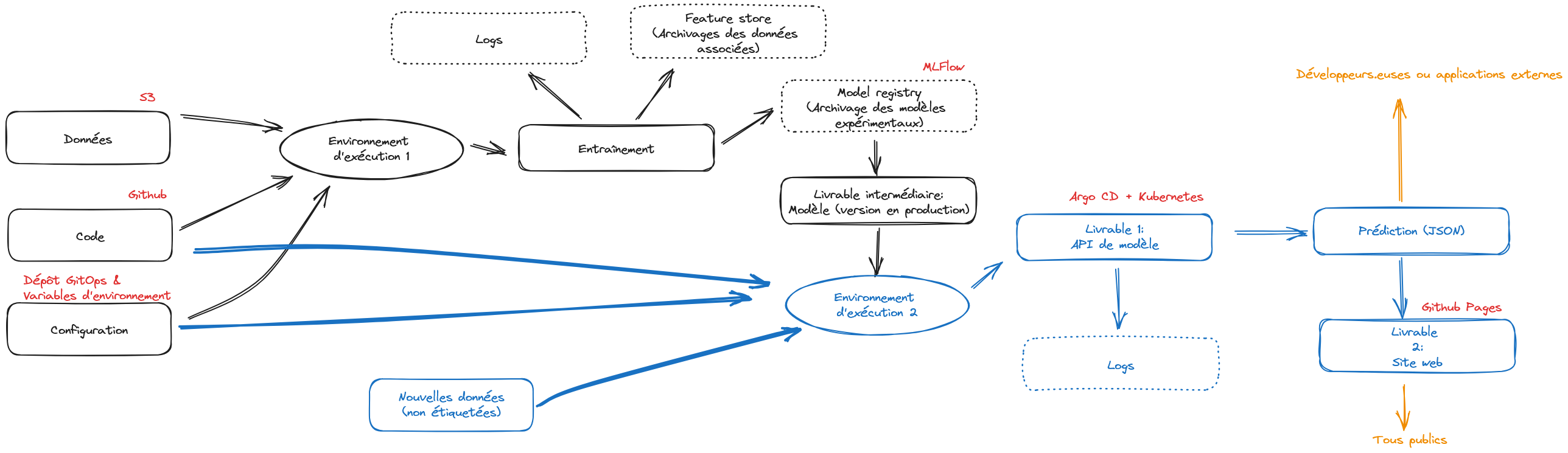

La Figure 3 illustre l’horizon auquel nous aboutirons à la fin de cette application. Nous désynchronisons les étapes d’entraînement et de prédiction, en identifiant mieux les pré-requis de chacune et en adoptant des briques technologiques adaptées à celles-ci. Les noms présents sur cette figure sont encore obscurs, c’est normal, mais ils vous deviendrons familiers si vous adoptez une infrastructure et une méthode de travail à l’état de l’art.

Il est important de bien lire les consignes et d’y aller progressivement. Certaines étapes peuvent être rapides, d’autres plus fastidieuses ; certaines être assez guidées, d’autres vous laisser plus de liberté. Si vous n’effectuez pas une étape, vous risquez de ne pas pouvoir passer à l’étape suivante qui en dépend.

Bien que l’exercice soit applicable sur toute configuration bien faite, nous recommandons de privilégier l’utilisation du SSP Cloud, où tous les outils nécessaires sont pré-installés et pré-configurés. Le service VSCode ne sera en effet que le point d’entrée pour l’utilisation d’outils plus exigeants sur le plan de l’infrastructure: Argo, MLFLow, etc.

Ce que cette application ne couvre pas (pour le moment)

A l’heure actuelle, cette application se concentre sur la mise en oeuvre fiable de l’entraînement de modèles de machine learning. Comme vous pouvez le voir, quand on part d’aussi loin qu’un projet monolithique dans un notebook, c’est un travail conséquent d’en arriver à un pipeline pensé pour la production. Cette application vise à vous sensibiliser au fait qu’avoir la Figure 3 en tête et adopter une organisation de travail et faire des choix techniques adéquats, vous fera économiser des dizaines voire centaines d’heures lorsque votre modèle aura vocation à passer en production.

A l’heure actuelle, cette application ne se concentre que sur une partie du cycle de vie d’un projet data ; il y a déjà fort à faire. Nous nous concentrons sur l’entraînement et la mise à disposition d’un modèle à des fins opérationnelles. C’est la première partie du cycle de vie d’un modèle. Dans une approche MLOps, il faut également penser la maintenance de ce modèle et les enjeux que représentent l’arrivée continue de nouvelles données, ou le besoin d’en collecter de nouvelles à travers des annotations, sur la qualité prédictive d’un modèle. Toute entreprise qui ne pense pas cet après est vouée à se faire doubler par un nouveau venu. Une prochaine version de cette application permettra certainement d’illustrer certains des enjeux afférants à la vie en production d’un modèle (supervision, annotations…) sur notre cas d’usage.

Il convient aussi de noter que nous ne faisons que parcourir la surface des sujets que nous évoquons. Ce cours, déjà dense, deviendrait indigeste si nous devions présenter chaque outil dans le détail. Nous laissons donc les curieux approfondir chacun des outils que nous présentons pour découvrir comment en tirer le maximum (et si vous avez l’impression que nous oublions des éléments cruciaux, les issues et pull requests sont bienvenues).

Partie 0 : initialisation du projet

Nous allons prendre comme point de départ un projet livré exclusivement avec un notebook, à la manière d’un challenge Kaggle. Vous pourrez ainsi voir à quel point ce type de livrable est très loin d’être satisfaisant si on veut que le projet soit réutilisable.

Les premières étapes consistent à mettre en place son environnement de travail sur Github:

Générer un jeton d’accès (token) sur

GitHubafin de permettre l’authentification en ligne de commande à votre compte. La procédure est décrite ici. Vous ne voyez ce jeton qu’une fois, ne fermez pas la page de suite.Mettez de côté ce jeton en l’enregistrant dans un gestionnaire de mot de passe ou dans l’espace “Mon compte” du

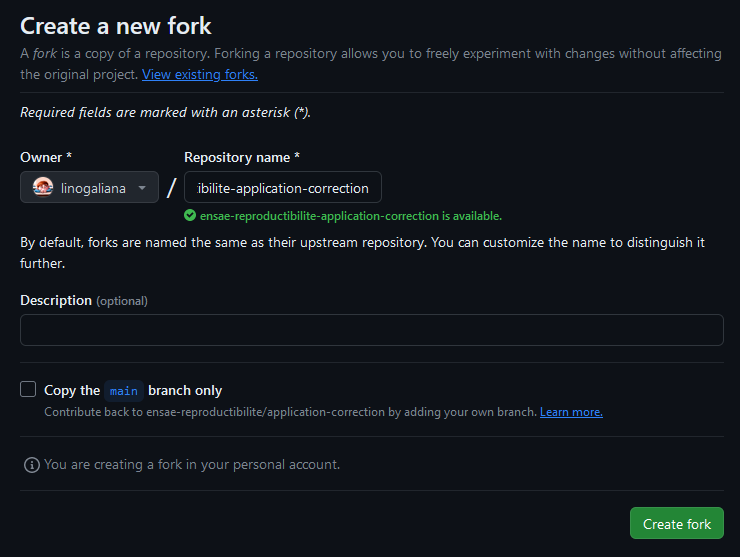

SSP Cloud.Forker le dépôt

Github: https://github.com/ensae-reproductibilite/application en faisant attention à une option :- Décocher la case “Copy the

mainbranch only” afin de copier également les tagsGitqui nous permettront de faire les checkpoint.

- Décocher la case “Copy the

Ce que vous devriez voir sur la page de création du fork.

Nous recommandons d’utiliser, tout au long de ce projet, l’environnement de développement VSCode. En plus d’être très bien construit, les nombreuses extensions disponibles rendent celui-ci adaptable à tous nos besoins. Comme il s’agit de l’outil sur lequel vous passerez votre quotidien, n’hésitez pas à personnaliser celui-ci grâce aux nombreuses ressources disponibles en ligne1.

Il est maintenant possible de ce lancer dans la création de l’environnement de travail:

- Ouvrir un service

VSCodesur le SSP Cloud. Vous pouvez aller dans la pageMy Serviceset cliquer surNew service. Sinon, vous pouvez initialiser la création du service en cliquant directement ici. Modifier les options suivantes:- Dans l’onglet

Role, sélectionner le rôleAdmin; - Dans l’onglet

Networking, cliquer sur “Enable a custom service port” et laisser la valeur par défaut 5000 pour le numéro du port - (optionnel) Pour préinstaller quelques extensions supplémentaires à celles disponibles par défaut, dans l’onglet

Init, dans le champPersonalInit, renseigner l’adresse https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/init.sh

- Dans l’onglet

- Clôner votre dépôt

Githuben utilisant le terminal depuisVisual Studio(Terminal > New Terminal) et en passant directement le token dans l’URL selon cette structure:

terminal

git clone https://$TOKEN@github.com/$USERNAME/application.gitoù $TOKEN et $USERNAME sont à remplacer, respectivement, par le jeton que vous avez généré précédemment et votre nom d’utilisateur.

Le script d’initialisation proposé

Ce script initialise quelques extensions intéressantes pour le développement de projets utilisant Python ou des fichiers textes type Markdown ou YAML: diagnostic, mise en forme automatisée, etc.

#!/bin/bash

# Define the configuration directory for VS Code

VSCODE_CONFIG_DIR="$HOME/.local/share/code-server/User"

# Create the configuration directory if necessary

mkdir -p "$VSCODE_CONFIG_DIR"

# User settings file

SETTINGS_FILE="$VSCODE_CONFIG_DIR/settings.json"

code-server --install-extension yzhang.markdown-all-in-one

code-server --install-extension oderwat.indent-rainbow

code-server --install-extension tamasfe.even-better-toml

code-server --install-extension aaron-bond.better-comments

code-server --install-extension github.vscode-github-actions

# Replace default flake8 linter with project-preconfigured ruff

code-server --uninstall-extension ms-python.flake8

code-server --install-extension charliermarsh.ruff

jq '. + {

"workbench.colorTheme": "Default Dark Modern", # Set the theme

"editor.rulers": [80, 100, 120], # Add specific vertical rulers

"files.trimTrailingWhitespace": true, # Automatically trim trailing whitespace

"files.insertFinalNewline": true, # Ensure files end with a newline

"flake8.args": [

"--max-line-length=100" # Max line length for Python linting

]

}' "$SETTINGS_FILE" > "$SETTINGS_FILE.tmp" && mv "$SETTINGS_FILE.tmp" "$SETTINGS_FILE"Si, dans quelques jours, vous désirez relancer un service avec cette configuration, vous pouvez cliquer sur ce lien:

En cliquant sur l’onglet Git, vous pouvez renseigner directement votre URL de la forme https://github.com/username/depot.git: cela clônera votre dépôt dans le service et injectera le token pour vous économiser l’authentification à venir lors de la phase de push.

Partie 1 : qualité du script

Cette première partie vise à rendre le projet conforme aux bonnes pratiques présentées dans le cours.

Elle fait intervenir les notions suivantes :

- Utilisation du terminal (voir Linux 101) ;

- Qualité du code (voir Qualité du code) ;

- Architecture de projets (voir Architecture des projets) ;

- Contrôle de version avec

Git(voir RappelsGit) ; - Travail collaboratif avec

GitetGitHub(voir RappelsGit).

Le plan de la partie est le suivant :

- S’assurer que le script fonctionne ;

- Nettoyer le code des scories formelles avec un linter et un formatter ;

- Paramétrisation du script ;

- Utilisation de fonctions.

Étape 1 : s’assurer que le script s’exécute correctement

On va partir du fichier notebook.py qui reprend le contenu du notebook2 mais dans un script classique. Le travail de nettoyage en sera facilité.

La première étape est simple, mais souvent oubliée : vérifier que le code fonctionne correctement. Pour cela, nous recommandons de faire un aller-retour entre le script ouvert dans VSCode et un terminal pour le lancer.

- Ouvrir dans

VSCodele scripttitanic.py; - Exécuter le script en ligne de commande (

python titanic.py)3 pour détecter les erreurs ; - Corriger les deux erreurs qui empêchent la bonne exécution ;

- Vérifier le fonctionnement du script en utilisant la ligne de commande:

terminal

python titanic.pyLe code devrait afficher des sorties.

Aide sur les erreurs rencontrées

La première erreur rencontrée est une alerte FileNotFoundError, la seconde est liée à un package.

Il est maintenant temps de commit les changements effectués avec Git4 :

terminal

git add titanic.py

git commit -m "Corrige l'erreur qui empêchait l'exécution"

git pushterminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli12

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli1

- 3

- Nettoyer derrière nous

Étape 2: utiliser un linter puis un formatter

On va maintenant améliorer la qualité de notre code en appliquant les standards communautaires. Pour cela, on va utiliser le linter classique PyLint et le formatter Black. Si vous désirez un outil deux en un, il est possible d’utiliser Ruff en complément ou substitut.

Ce nettoyage automatique du code permettra, au passage, de restructurer notre script de manière plus naturelle.

Le linter PyLint renvoie alors une série d’irrégularités, en précisant à chaque fois la ligne de l’erreur et le message d’erreur associé (ex : mauvaise identation). Il renvoie finalement une note sur 10, qui estime la qualité du code à l’aune des standards communautaires évoqués dans la partie Qualité du code.

- Diagnostiquer et évaluer la qualité de

titanic.pyavecPyLint. Regarder la note obtenue. - Utiliser le formatter ruff via la commande

ruff check titanic.pypour voir les problèmes recensés par celui-ci. Appliquer l’option--fixsuggérée pour commencer à formatter le fichier. Evaluer à nouveau ce fichier avecPyLint. - Utiliser

ruff format titanic.pypour modifier la mise en forme du fichier. - Réutiliser

PyLintpour diagnostiquer l’amélioration de la qualité du script et le travail qui reste à faire. - Comme la majorité du travail restant est à consacrer aux imports:

- Délimiter des parties dans votre code pour rendre sa structure plus lisible. Si des parties vous semblent être dans le désordre, vous pouvez réordonner le script (mais n’oubliez pas de le tester)

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli22

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli2

- 3

- Nettoyer derrière nous

Le code est maintenant lisible, il obtient à ce stade une note formelle proche de 10. Mais il n’est pas encore totalement intelligible ou fiable. Il y a notamment quelques redondances de code auxquelles nous allons nous attaquer par la suite. Néanmoins, avant cela, occupons-nous de mieux gérer certains paramètres du script: jetons d’API et chemin des fichiers.

Étape 3: gestion des paramètres

VSCode actif avec la configuration proposée dans l'application préliminaire, vous pouvez repartir de ce service:

Et ensuite, après avoir clôné le dépôt

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli22

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli2

- 3

- Nettoyer derrière nous

L’exécution du code et les résultats obtenus dépendent de certains paramètres définis dans le code. L’étude de résultats alternatifs, en jouant sur des variantes des (hyper)paramètres, est à ce stade compliquée car il est nécessaire de parcourir le code pour trouver ces paramètres. De plus, certains paramètres personnels comme des jetons d’API ou des mots de passe n’ont pas vocation à être présents dans le code.

Il est plus judicieux de considérer ces paramètres comme des variables d’entrée du script. Cela peut être fait de deux manières:

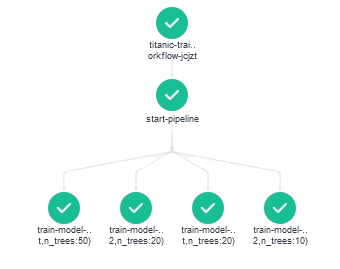

- Avec des arguments optionnels appelés depuis la ligne de commande (Application 3a). Cela peut être pratique pour mettre en oeuvre des tests automatisés mais n’est pas forcément pertinent pour toutes les variables. Nous allons montrer cet usage avec le nombre d’arbres de notre random forest ;

- En utilisant un fichier de configuration dont les valeurs sont importées dans le script principal (Application 3b).

Un exemple de définition d’un argument pour l’utilisation en ligne de commande

prenom.py

import argparse

parser = argparse.ArgumentParser(description="Qui êtes-vous?")

parser.add_argument(

"--prenom", type=str, default="Toto", help="Un prénom à afficher"

)

args = parser.parse_args()

print(args.prenom)Exemples d’utilisations en ligne de commande

terminal

python prenom.py

python prenom.py --prenom "Zinedine"- En s’inspirant de l’exemple ci-dessus 👆️, créer une variable

n_treesqui peut éventuellement être paramétrée en ligne de commande et dont la valeur par défaut est 20 ; - Tester cette paramétrisation en ligne de commande avec la valeur par défaut puis 2, 10 et 50 arbres.

L’exercice suivant permet de mettre en application le fait de paramétriser un script en utilisant des variables définies dans un fichier YAML.

- Installer le package

python-dotenvque nous allons utiliser pour charger notre jeton d’API à partir d’une variable d’environnement. - A partir de l’exemple de la documentation, utiliser la fonction

load_dotenvpour charger dansPythonnos variables d’environnement à partir d’un fichier (vous pouvez le créer mais ne pas le remplir encore avec les valeurs voulues, ce sera fait ensuite) - Créer la variable et vérifier la sortie de

Pythonen faisant tournertitanic.pyen ligne de commande

titanic.py

jeton_api = os.environ.get("JETON_API", "")

if jeton_api.startswith("$"):

print("API token has been configured properly")

else:

print("API token has not been configured")- Maintenant introduire la valeur voulue pour le jeton d’API dans le fichier d’environnement lu par

dotenv - S’il n’existe pas déjà, créer un fichier

.gitignore(cf. ChapitreGit). Ajouter dans ce fichier.envcar il ne faut pas committer ce fichier. Au passage ajouter__pycache__/au.gitignore5, cela évitera d’avoir à le faire ultérieurement ; - Créer un fichier

README.mdoù vous indiquez qu’il faut créer un fichier.envpour pouvoir utiliser l’API.

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli32

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli3

- 3

- Nettoyer derrière nous

Étape 4 : Privilégier la programmation fonctionnelle

Nous allons mettre en fonctions les parties importantes de l’analyse. Ceci facilitera l’étape ultérieure de modularisation de notre projet. Comme cela est évoqué dans les éléments magistraux de ce cours, l’utilisation de fonctions va rendre notre code plus concis, plus traçable, mieux documenté.

Cet exercice étant chronophage, il n’est pas obligatoire de le réaliser en entier. L’important est de comprendre la démarche et d’adopter fréquemment une approche fonctionnelle6. Pour obtenir une chaine entièrement fonctionnalisée, vous pouvez reprendre le checkpoint.

Pour commencer, cet exercice fait un petit pas de côté pour faire comprendre la manière dont les pipelines scikit sont un outil au service des bonnes pratiques.

Scikit ?

- Le pipeline

Scikitd’estimation et d’évaluation vous a été donné tel quel. Regardez, ci-dessous, le code équivalent sans utiliser de pipelineScikit:

Le code équivalent sans pipeline

from sklearn.impute import SimpleImputer

from sklearn.preprocessing import MinMaxScaler, OneHotEncoder

from sklearn.compose import ColumnTransformer

from sklearn.ensemble import RandomForestClassifier

from sklearn.metrics import confusion_matrix

import pandas as pd

import numpy as np

# Définition des variables

numeric_features = ["Age", "Fare"]

categorical_features = ["Embarked", "Sex"]

# PREPROCESSING ----------------------------

# Handling missing values for numerical features

num_imputer = SimpleImputer(strategy="median")

X_train[numeric_features] = num_imputer.fit_transform(X_train[numeric_features])

X_test[numeric_features] = num_imputer.transform(X_test[numeric_features])

# Scaling numerical features

scaler = MinMaxScaler()

X_train[numeric_features] = scaler.fit_transform(X_train[numeric_features])

X_test[numeric_features] = scaler.transform(X_test[numeric_features])

# Handling missing values for categorical features

cat_imputer = SimpleImputer(strategy="most_frequent")

X_train[categorical_features] = cat_imputer.fit_transform(X_train[categorical_features])

X_test[categorical_features] = cat_imputer.transform(X_test[categorical_features])

# One-hot encoding categorical features

encoder = OneHotEncoder(handle_unknown='ignore', sparse_output=False)

X_train_encoded = encoder.fit_transform(X_train[categorical_features])

X_test_encoded = encoder.transform(X_test[categorical_features])

# Convert encoded features into a DataFrame

X_train_encoded = pd.DataFrame(X_train_encoded, columns=encoder.get_feature_names_out(categorical_features), index=X_train.index)

X_test_encoded = pd.DataFrame(X_test_encoded, columns=encoder.get_feature_names_out(categorical_features), index=X_test.index)

# Drop original categorical columns and concatenate encoded ones

X_train = X_train.drop(columns=categorical_features).join(X_train_encoded)

X_test = X_test.drop(columns=categorical_features).join(X_test_encoded)

# MODEL TRAINING ----------------------------

# Defining the model

model = RandomForestClassifier(n_estimators=n_trees)

# Fitting the model

model.fit(X_train, y_train)

# EVALUATION ----------------------------

# Scoring

rdmf_score = model.score(X_test, y_test)

print(f"{rdmf_score:.1%} de bonnes réponses sur les données de test pour validation")

# Confusion matrix

print(20 * "-")

print("matrice de confusion")

print(confusion_matrix(y_test, model.predict(X_test)))Voyez-vous l’intérêt de l’approche par pipeline en termes de lisibilité, évolutivité et fiabilité ?

Créer un notebook qui servira de brouillon. Y introduire le code suivant:

Le code à copier-coller dans un notebook

import pandas as pd

from sklearn.preprocessing import OneHotEncoder, MinMaxScaler

from sklearn.ensemble import RandomForestClassifier

from sklearn.impute import SimpleImputer

from sklearn.pipeline import Pipeline

from sklearn.compose import ColumnTransformer

train = pd.read_csv("train.csv")

test = pd.read_csv("test.csv")

X_train, y_train = train.drop("Survived", axis="columns"), train["Survived"]

X_test, y_test = test.drop("Survived", axis="columns"), train["Survived"]

MAX_DEPTH = None

MAX_FEATURES = "sqrt"

n_trees=20

numeric_features = ["Age", "Fare"]

categorical_features = ["Embarked", "Sex"]

# Variables numériques

numeric_transformer = Pipeline(

steps=[

("imputer", SimpleImputer(strategy="median")),

("scaler", MinMaxScaler()),

]

)

# Variables catégorielles

categorical_transformer = Pipeline(

steps=[

("imputer", SimpleImputer(strategy="most_frequent")),

("onehot", OneHotEncoder()),

]

)

# Preprocessing

preprocessor = ColumnTransformer(

transformers=[

("Preprocessing numerical", numeric_transformer, numeric_features),

(

"Preprocessing categorical",

categorical_transformer,

categorical_features,

),

]

)

# Pipeline

pipe = Pipeline(

[

("preprocessor", preprocessor),

("classifier", RandomForestClassifier(

n_estimators=n_trees,

max_depth=MAX_DEPTH,

max_features=MAX_FEATURES

)),

]

)

pipe.fit(X_train, y_train)Afficher ce pipeline dans une cellule de votre notebook. Cela vous aide-t-il mieux à comprendre les différentes étapes du pipeline de modélisation ?

Comment pouvez-vous accéder aux étapes de preprocessing ?

- Comment pouvez-vous faire pour appliquer le pipeline de preprocessing des variables numériques (et uniquement celui-ci) à ce DataFrame ?

Le DataFrame à créer pour appliquer un bout de notre pipeline

import numpy as np

new_data = {

"Age": [22, np.nan, 35, 28, np.nan],

"Fare": [7.25, 8.05, np.nan, 13.00, 15.50]

}

new_data = pd.DataFrame(new_data)- Normalement ce code ne devrait pas prendre plus d’une demie-douzaine de lignes. Sans pipeline le code équivalent, beaucoup plus verbeux et moins fiable, ressemble à celui-ci

Le code équivalent, sans pipeline

import pandas as pd

import numpy as np

from sklearn.impute import SimpleImputer

from sklearn.preprocessing import MinMaxScaler

# Définition des nouvelles données

new_data = pd.DataFrame({

"Age": [25, np.nan, 40, 33, np.nan],

"Fare": [10.50, 7.85, np.nan, 22.00, 12.75]

})

# Définition des transformations (même que dans le pipeline)

num_imputer = SimpleImputer(strategy="median")

scaler = MinMaxScaler()

# Apprentissage des transformations sur X_train (assumant que vous l'avez déjà)

X_train_numeric = X_train[["Age", "Fare"]] # Supposons que X_train existe

num_imputer.fit(X_train_numeric)

scaler.fit(num_imputer.transform(X_train_numeric))

# Transformation des nouvelles données

new_data_imputed = num_imputer.transform(new_data)

new_data_scaled = scaler.transform(new_data_imputed)

# Création du DataFrame final

new_data_preprocessed = pd.DataFrame(

new_data_scaled,

columns=["Age_scaled", "Fare_scaled"] # Générer des noms de colonnes adaptés

)

# Affichage du DataFrame

print(new_data_preprocessed)- Imaginons que vous ayez déjà des données préprocessées:

Créer des données préprocessées

import numpy as np

import pandas as pd

new_data = pd.DataFrame({

"Age": [25, np.nan, 40, 33, np.nan],

"Fare": [10.50, 7.85, np.nan, 22.00, 12.75],

"Embarked": ["S", "C", np.nan, "Q", "S"],

"Sex": ["male", "female", "male", np.nan, "female"]

})

new_y = np.random.randint(0, 2, size=len(new_data))

preprocessed_data = pd.DataFrame(

pipe[:-1].transform(new_data),

columns = preprocessor_numeric.get_feature_names_out()

)

preprocessed_data- Déterminer le score en prédiction sur ces données

Maintenant, revenons à notre chaine de production et appliquons des fonctions pour la rendre plus lisible, plus fiable et plus modulaire.

Cette application peut être chronophage, vous pouvez aller plus ou moins loin dans la fonctionalisation de votre script en fonction du temps dont vous disposez.

- Créer une fonction qui intègre les différentes étapes du pipeline (preprocessing et définition du modèle). Cette fonction prend en paramètre le nombre d’arbres (argument obligatoire) et des arguments optionnels supplémentaires (les colonnes sur lesquelles s’appliquent les différentes étapes du pipeline,

max_depthetmax_features). - Créer une fonction d’évaluation renvoyant le score obtenu et la matrice de confusion, à l’issue d’une estimation (mais cette estimation est faite en amont de la fonction, pas au sein de celle-ci)

- Déplacer toutes les fonctions ensemble, en début de script. Si besoin, ajouter des paramètres à votre fichier d’environnement pour créer de nouvelles variables comme les chemins des données.

- En profiter pour supprimer le code zombie qu’on a gardé jusqu’à présent mais qui ne correspond pas vraiment à des opérations utiles à notre chaine de production

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli42

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli4

- 3

- Nettoyer derrière nous

Cela ne se remarque pas encore vraiment car nous avons de nombreuses définitions de fonctions mais notre chaine de production est beaucoup plus concise (le script fait environ 150 lignes dont une centaine issues de définitions de fonctions génériques). Cette auto-discipline facilitera grandement les étapes ultérieures. Cela aurait été néanmoins beaucoup moins coûteux en temps d’adopter ces bons gestes de manière plus précoce.

Partie 2 : adoption d’une structure modulaire

Dans la partie précédente, on a appliqué de manière incrémentale de nombreuses bonnes pratiques vues tout au long du cours. Ce faisant, on s’est déjà considérablement rapprochés d’un possible partage du code : celui-ci est lisible et intelligible. Le code est proprement versionné sur un dépôt GitHub.

Cependant, le projet est encore perfectible: il est encore difficile de rentrer dedans si on ne sait pas exactement ce qu’on recherche. L’objectif de cette partie est d’isoler les différentes étapes de notre pipeline. Outre le gain de clarté pour notre projet, nous économiserons beaucoup de peines pour la mise en production ultérieure de notre modèle.

Dans cette partie nous allons continuer les améliorations incrémentales de notre projet avec les étapes suivantes:

- Modularisation du code

Pythonpour séparer les différentes étapes de notre pipeline ; - Adopter une structure standardisée pour notre projet afin d’autodocumenter l’organisation de celui-ci ;

- Documenter les packages indispensables à l’exécution du code ;

- Stocker les données dans un environnement adéquat afin de continuer la démarche de séparer conceptuellement les données du code en de la configuration.

Étape 1 : modularisation

Nous allons profiter de la modularisation pour adopter une structure applicative pour notre code. Celui-ci n’étant en effet plus lancé que depuis la ligne de commande, on peut considérer qu’on construit une application générique où un script principal (main.py) encapsule des éléments issus d’autres scripts Python.

- Déplacer les fonctions dans une série de fichiers dédiés:

build_pipeline.py: script avec la définition du pipelinetrain_evaluate.py: script avec les fonctions d’évaluation du projet

- Spécifier les dépendances (i.e. les packages à importer) dans les modules pour que ceux-ci puissent s’exécuter indépendamment ;

- Renommer

titanic.pyenmain.pypour suivre la convention de nommage des projetsPython; - Importer les fonctions nécessaires à partir des modules.

- Vérifier que tout fonctionne bien en exécutant le script

mainà partir de la ligne de commande :

terminal

python main.py- Optionnel: profitez en pour mettre un petit coup de formatter à votre projet, si vous ne l’avez pas fait régulièrement.

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli52

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli5

- 3

- Nettoyer derrière nous

Étape 2 : adopter une architecture standardisée de projet

On dispose maintenant d’une application Python fonctionnelle. Néanmoins, le projet est certes plus fiable mais sa structuration laisse à désirer et il serait difficile de rentrer à nouveau dans le projet dans quelques temps.

Etat actuel du projet 🙈

├── .gitignore

├── .env

├── data.csv

├── train.csv

├── test.csv

├── README.md

├── build_pipeline.py

├── train_evaluate.py

├── titanic.ipynb

└── main.pyComme cela est expliqué dans la partie Structure des projets, on va adopter une structure certes arbitraire mais qui va faciliter l’autodocumentation de notre projet. De plus, une telle structure va faciliter des évolutions optionnelles comme la packagisation du projet. Passer d’une structure modulaire bien faite à un package est quasi-immédiat en Python.

On va donc modifier l’architecture de notre projet pour la rendre plus standardisée. Pour cela, on va s’inspirer des structures cookiecutter qui génèrent des templates de projet. En l’occurrence notre source d’inspiration sera le template datascience issu d’un effort communautaire.

L’idée de cookiecutter est de proposer des templates que l’on utilise pour initialiser un projet, afin de bâtir à l’avance une structure évolutive. La syntaxe à utiliser dans ce cas est la suivante :

terminal

pip install cookiecutter

cookiecutter https://github.com/drivendata/cookiecutter-data-scienceIci, on a déjà un projet, on va donc faire les choses dans l’autre sens : on va s’inspirer de la structure proposée afin de réorganiser celle de notre projet selon les standards communautaires.

En s’inspirant du cookiecutter data science on va adopter la structure suivante:

Structure recommandée

application

├── main.py

├── .env

├── README.md

├── data

│ ├── raw

│ │ └── data.csv

│ └── derived

│ ├── test.csv

│ └── train.csv

├── notebooks

│ └── titanic.ipynb

└── src

├── pipeline

│ └── build_pipeline.py

└── models

└── train_evaluate.py- (optionnel) Analyser et comprendre la structure de projet proposée par le template ;

- Modifier l’arborescence du projet selon le modèle ;

- Mettre à jour l’import des dépendances, le fichier de configuration et

main.pyavec les nouveaux chemins ;

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli62

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli6

- 3

- Nettoyer derrière nous

Étape 3: mieux tracer notre chaine de production

Indiquer l’environnement minimal de reproductibilité

Le script main.py nécessite un certain nombre de packages pour être fonctionnel. Chez vous les packages nécessaires sont bien sûr installés mais êtes-vous assuré que c’est le cas chez la personne qui testera votre code ?

Afin de favoriser la portabilité du projet, il est d’usage de “fixer l’environnement”, c’est-à-dire d’indiquer dans un fichier toutes les dépendances utilisées ainsi que leurs version. Nous proposons de créer un fichier requirements.txt minimal, sur lequel nous reviendrons dans la partie consacrée aux environnements reproductibles.

Le fichier requirements.txt est conventionnellement localisé à la racine du projet. Ici on ne va pas fixer les versions, on raffinera ce fichier ultérieurement.

requirements.txt

- Créer un fichier

requirements.txtavec la liste des packages nécessaires - Ajouter une indication dans

README.mdsur l’installation des packages grâce au fichierrequirements.txt

Tracer notre chaîne

Quand votre projet passera en production, vous aurez un accès limité à celui-ci. Il est donc important de faire remonter, par le biais du logging des informations critiques sur votre projet qui vous permettront de savoir où il en est (si vous avez accès à la console où il tourne) ou là où il s’est arrêté.

L’utilisation de print montre rapidement ses limites pour cela. Les informations enregistrées ne persistent pas après la session et sont quelques peu rudimentaires.

Pour faire du logging, la librairie consacrée depuis longtemps en Python est… logging. Il existe aussi une librairie nommée loguru qui est un peu plus simple à configurer (l’instanciation du logger est plus aisée) et plus agréable grâce à ses messages en couleurs qui permettent de visuellement trier les informations.

L’exercice suivant peut être fait avec les deux librairies, cela ne change pas grand chose. Les prochaines applications repartiront de la version utilisant la librairie standard logging.

- Aller sur la documentation de la librairie ici et sur ce tutoriel pour trouver des sources d’inspiration sur la configuration et l’utilisation de

logging. - Pour afficher les messages dans la console et dans un fichier de log, s’inspirer de cette réponse sur stack overflow.

- Tester en ligne de commande votre code et observer le fichier de log

- Installer

loguruet l’ajouter aurequirements.txt - En s’aidant du

READMEdu projet surGithub, remplacer nosprintpar différents types de messages (info, success, etc.). - Tester l’exécution du script en ligne de commande et observer vos sorties

- Mettre à jour le logger pour enregistrer dans un fichier de log. Ajouter celui-ci au

.gitignorepuis tester en ligne de commande votre script. Ouvrir le fichier en question, refaites tourner le script et regardez son évolutoin. - Il est possible avec

logurude capturer les erreurs des fonctions grâce au système de cache décrit ici. Introduire une erreur dans une des fonctions (par exemple danscreate_pipeline) avec un code du typeraise ValueError("Problème ici")

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli72

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli7

- 3

- Nettoyer derrière nous

Étape 4 : stocker les données de manière externe

Jusqu’à présent, nous avons une chaîne reproductible puisque si on récupère le code, on récupère aussi les données. Ce n’est pas une bonne pratique. Nous allons maintenant séparer conceptuellement code et données. Cela va nous amener à nous poser trois questions : où stocker les données ? dans quel format ? comment les lire ?

La réponse à ces trois formats permettra d’avoir le nec plus ultra des bonnes pratiques: des données au format Parquet hébergé sur le cloud et lues dans Python par l’intermédiaire de DuckDB.

Pour cette partie, il faut avoir un service VSCode dont les jetons d’authentification à S3 sont valides. Si vous avez un doute, vous reporter à Tip 1.

Pour les prochaines applications, on va supposer l’utilisation d’un système de stockage cloud de type S3 (pour en savoir plus sur l’intérêt de cette approche, se reporter au chapitre dédié).

Sans perte de généralité, on va supposer que le S3 en question est celui du SSPCloud (mais cela fonctionnerait de manière assez transparente si nous proposions d’utiliser un cloud provider privé comme AWS). Pour en savoir plus sur l’adaptation de ce tutoriel hors du SSPCloud, se reporter vers l’encadré dédié (Important 1).

Pour que votre Python interagisse avec S3, il vous faut des jetons d’authentification. Ils permettent de dire à S3 que c’est bien vous qui essayez de consommer la donnée à laquelle vous avez le droit par le biais d’un Python qu’il ne connaît pas a priori.

Des jetons d’authentification sont créés automatiquement pour vous lorsque vous lancez un service interactif VSCode sur le SSPCloud. Ils ont cependant une durée de vie limitée (5 jours). Si votre service a des jetons ayant expiré, vous allez avoir une erreur 403 lorsque vous essaierai d’interagir avec S3.

Deux approches sont possibles:

- Récupérer des jetons valides sur https://datalab.sspcloud.fr/account/storage et les renseigner à l’endroit adéquat dans votre service VSCode.

- Créer un nouveau service qui bénéficiera automatiquement de l’injection de jetons à jour.

La 2e voie est recommandée. Le plus simple est de 1/ cliquer sur le bouton suivant

2/ remplir l’onglet Git avec l’url de votre dépôt pour bénéficier du clonage automatique de celui-ci et 3/ faire le checkpoint post appli7.

De cette manière votre VSCode sera presque prêt à l’emploi, à l’image de ce que vous aviez fait pour l’application 0. Il vous suffira d’ouvrir un terminal et faire pip install -r requirements.txt && python main.py pour pouvoir démarrer l’application.

VSCode actif avec la configuration proposée dans l'application préliminaire, vous pouvez repartir de ce service:

Et ensuite, après avoir clôné le dépôt

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli72

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli7

- 3

- Nettoyer derrière nous

L’étape précédente nous a permis d’isoler la configuration. Nous avons conceptuellement isolé les données du code lors des applications précédentes. Cependant, nous n’avons pas été au bout du chemin car le stockage des données reste conjoint à celui du code. Nous allons maintenant dissocier ces deux éléments.

SSPCloud ? (une idée saugrenue mais sait-on jamais)

Les exemples à venir peuvent très bien être répliqués sur n’importe quel cloud provider qui propose une solution de type S3, qu’il s’agisse d’un cloud provider privé (AWS, GCP, Azure, etc.) ou d’une réinstanciation ad hoc du projet Onyxia, le logiciel derrière le SSPCloud.

Pour un système de stockage S3, il suffit de changer les paramètres de connexion de s3fs (endpoint, region, etc.). Pour les stockages sur GCP, les codes sont presque équivalents, il suffit de remplacer la librairie s3fs par gcfs; ces deux librairies sont en fait des briques d’un standard plus général de gestion de systèmes de fichiers en Python ffspec.

Le scénario type de la première partie de l’application (appli8a) est que nous avons une source brute, reçue sous forme de CSV, dont on ne peut changer le format. Un doublon de celle-ci a été écrit sur S3 et nous allons utiliser le fichier depuis cet emplacement Il aurait été idéal d’avoir un format plus adapté au traitement de données pour ce fichier mais ce n’était pas de notre ressort.

Notre chaine va aller chercher ce fichier, travailler dessus jusqu’à valoriser celui-ci sous la forme de notre matrice de confusion. Néanmoins, ici, nous avons une donnée qui ne change jamais. On n’a pas de mise à jour fréquente de données qui justifie de ne pas changer, une fois pour toute, notre format de données afin d’en adopter un plus pertinent. En l’occurrence, nous allons utiliser le format Parquet. C’est l’objet de l’appli 8c.

Cette application va se dérouler en quatre temps:

- Upload de notre source brute (CSV) sur S3.

- Illustration de l’usage des librairies cloud native pour lire celle-ci.

- Conversion au format

Parquetde cette donnée et utilisation deDuckDBpour la lire. - Partage public de cette donnée pour la rendre accessible de manière plus simple à nos futures applications.

S3

Le SSPCloud repose sur une implémentation particulière du protocole S3 qui s’appelle MinIO. Cela étend les fonctionnalités de manipulation de fichiers en ligne de commande à des données n’étant pas présentes dans le filesystem local mais dans le cloud. En pratique

En pratique, l’implémentation MinIO permet notamment de manipuler des fichiers à distance comme s’ils étaient en local. Les commandes de manipulation de fichier du chapitre Linux 101 (lister, copier, supprimer…) sont étendues grâce à l’ajout d’un petit mc devant celle-ci.

Illustrons cela en copiant les données de départ vers votre bucket personnel.

Indice

Structure à adopter:

terminal

BUCKET_PERSONNEL="nom_utilisateur_sspcloud"

mc cp data.csv s3/${BUCKET_PERSONNEL}/ensae-reproductibilite/data/raw/data.csvBUCKET_PERSONNEL, l’emplacement de votre bucket personnel

Avant de modifier notre code Python, on va lister les fichiers se trouvant dans notre bucket. En ligne de commande, sur notre poste local, on ferait ls (cf. Linux 101). Cela ne va pas beaucoup différer avec les librairies cloud native:

terminal

- 1

- Changer avec le bucket

- 2

- Changer en fonction du chemin voulu

En utilisant l’explorateur de fichiers S3 du SSPCloud (datalab.sspcloud.fr/file-explorer), faites une deuxième vérification que vos données sont bien sauvegardées sur S3.

Vous pouvez ensuite supprimer le CSV de données présent dans votre dossier local, il ne nous sera plus utile.

On va maintenant lire directement une donnée stockée sur S3 avec Python. Pour illustrer le fait qu’être sur un système cloud avec les librairies adaptées change peu notre code, on va lire directement un fichier CSV stocké sur le SSPCloud, sans passer par un fichier en local7.

Pour illustrer la cohérence avec un système de fichier local, voici trois solutions pour lire le fichier que vous venez de mettre sur S3 (s’appuyant sur s3fs, Arrow ou DuckDB). Attention, il faut avoir des jetons de connexion à S3 à jour. Si vous avez cette erreur

A client error (InvalidAccessKeyId) occurred when calling the ListBuckets operation: The AWS Access Key Id you provided does not exist in our records.

c’est que vos identifiants de connexion ne sont plus à jour (pour des raisons de sécurité, ils sont régulièrement renouvelés). Dans ce cas, consulter Important 1.

S3

Cet exercice illustre trois manières de lire des données sur S3 au format CSV. Ce choix est arbitraire car il existe de nombreux frameworks concurrents ou complémentaires à Pandas, Arrow ou DuckDB qui permettent de lire des données depuis S3.

Pour le moment on va garder comme framework de prédilection Pandas mais la bascule vers Parquet nous fera privilégier DuckDB dans les prochaines applications.

Dans un notebook, copier-coller et mettre à jour ces deux variables qui seront utilisées dans différents exemples:

- 1

- Changer avec le bucket

- 2

- Changer en fonction du chemin voulu

Maintenant lire la donnée depuis S3 avec ce code:

import s3fs

import pandas as pd

fs = s3fs.S3FileSystem(client_kwargs={"endpoint_url": "https://minio.lab.sspcloud.fr"})

with fs.open(f"s3://{MY_BUCKET}/{CHEMIN_FICHIER}") as f:

df = pd.read_csv(f)

dfimport s3fs

from pyarrow import csv

fs = s3fs.S3FileSystem(client_kwargs={"endpoint_url": "https://minio.lab.sspcloud.fr"})

with fs.open(f"s3://{MY_BUCKET}/{CHEMIN_FICHIER}") as f:

df = csv.read_csv(f)

dfimport os

import duckdb

con = duckdb.connect(database=":memory:")

query_definition = f"SELECT * FROM read_csv('s3://{MY_BUCKET}/{CHEMIN_FICHIER}')"

df = con.sql(query_definition)

dfPour illustrer le fonctionnement simple de S3 avec les fichiers Parquet, on propose de faire la même chose. Ici il n’est pas pertinent de mesurer le gain de temps car le fichier est très léger en CSV et s’importe ainsi instantanément. Pour faire des exercices plus pertinents sur ce sujet, afin de découvrir certaines bonnes pratiques, regarder les exercices supplémentaires dans le chapitre dédié à Parquet).

S3

D’abord, on va convertir notre fichier au format Parquet avec ce code (à faire tourner qu’une fois donc à ne pas mettre dans main.py mais dans un notebook ou un script jetable)

import os

import duckdb

1MY_BUCKET = "mon_nom_utilisateur_sspcloud"

2CHEMIN_FICHIER = "ensae-reproductibilite/data/raw/data.csv"

con = duckdb.connect(database=":memory:")

query_definition = f"SELECT * FROM read_csv('s3://{MY_BUCKET}/{CHEMIN_FICHIER}')"

con.sql(

f"""

COPY (

SELECT *

FROM read_csv_auto('s3://{MY_BUCKET}/{CHEMIN_FICHIER}')

)

TO 's3://{MY_BUCKET}/{CHEMIN_FICHIER.replace("csv", "parquet")}'

(FORMAT PARQUET);

"""

)- 1

- Changer avec le bucket

- 2

- Changer en fonction du chemin voulu

- 1

- Remplacer ici par la valeur appropriée

- 2

- Changer en fonction du chemin voulu

import s3fs

import pandas as pd

chemin

fs = s3fs.S3FileSystem(client_kwargs={"endpoint_url": "https://minio.lab.sspcloud.fr"})

df = pd.read_parquet(f"s3://{MY_BUCKET}/{CHEMIN_PARQUET}", filesystem=fs)import pyarrow as pa

import pyarrow.parquet as pq

s3 = pa.fs.S3FileSystem(endpoint_override ="https://minio.lab.sspcloud.fr")

df = pq.read_table(f"{MY_BUCKET}/{CHEMIN_PARQUET}", filesystem=s3)

dfimport os

import duckdb

con = duckdb.connect(database=":memory:")

query_definition = f"SELECT * FROM read_parquet('s3://{MY_BUCKET}/{CHEMIN_PARQUET}')"

df = con.sql(query_definition)

dfParquet

Nous n’avons pas explicité pourquoi Parquet est un choix pertinent pour la plupart des chaînes data. Ici la donnée est de taille réduite, cela ne nous pénalisera pas beaucoup de faire du CSV et du Pandas même si nous recommandons plutôt de faire du Parquet et de pousser le plus loin possible DuckDB avant de revenir à Pandas.

Pour découvrir, en pratique, les raisons de ces choix techniques, vous pouvez aller voir les exercices supplémentaires à la fin du chapitre sur les données).

Parquet avec DuckDB

Par défaut, le contenu de votre bucket est privé, seul vous y avez accès. Pour pouvoir lire votre donnée, vos applications externes devront utiliser des jetons vous identifiant. Ici, comme nous utilisons une donnée publique, vous pouvez rendre accessible celle-ci à tous en lecture. Dans le jargon S3, cela signifie donner un accès anonyme à votre donnée.

Le modèle de commande à utiliser dans le terminal est le suivant:

terminal

1BUCKET_PERSONNEL="nom_utilisateur_sspcloud"

mc anonymous set download s3/${BUCKET_PERSONNEL}/ensae-reproductibilite/data/raw/- 1

- Remplacer par le nom de votre bucket.

Les URL de téléchargement seront de la forme https://minio.lab.sspcloud.fr/<BUCKET_PERSONNEL>/ensae-reproductibilite/data/raw/<filename>.<extension>

On va adapter progressivement notre chaîne à l’utilisation du format Parquet.

D’abord, il faut faire évoluer nos chemins:

1URL_RAW = ""

data_path = os.environ.get("data_path", URL_RAW)- 1

-

Modifier avec

URL_RAWun lien de la forme"https://minio.lab.sspcloud.fr/${BUCKET_PERSONNEL}/ensae-reproductibilite/data/raw/data.parquet"(ne laissez pas${BUCKET_PERSONNEL}, remplacez par la vraie valeur!).

Maintenant, il faut lire les données Parquet avec DuckDB. Modifier le code d’import des données pour utiliser DuckDB plutôt que Pandas. Vous pouvez, après avoir importé les données, convertir à nouveau en DataFrame Pandas avec la méthode to_df.

Ne pas oublier de mettre à jour 1/ le .gitignore 2/ requirements.txt pour être en mesure de réinstaller les packages si nécessaire.

S3

Remplacer la définition de

data_pathpour utiliser, par défaut, directement l’URL dans l’import. Modifier, si cela est pertinent, aussi votre fichier.env.Ajouter le dossier

data/au.gitignoreainsi que les fichiers*.parquetSupprimer le dossier

datade votre projet et faitesgit rm --cached -r dataVérifier le bon fonctionnement de votre application.

Maintenant qu’on a arrangé la structure de notre projet, c’est l’occasion de supprimer le code qui n’est plus nécessaire au bon fonctionnement de notre projet (cela réduit la charge de maintenance8).

Pour vous aider, vous pouvez utiliser vulture de manière itérative pour vous assister dans le nettoyage de votre code.

terminal

pip install vulture

vulture .Exemple de sortie

terminal

vulture .src/data/import_data.py:3: unused function 'split_and_count' (60% confidence)

src/pipeline/build_pipeline.py:12: unused function 'split_train_test' (60% confidence)terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli82

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli8

- 3

- Nettoyer derrière nous

Partie 2bis: packagisation de son projet (optionnel)

Cette série d’actions n’est pas forcément pertinente pour tous les projets. Elle fait un peu la transition entre la modularité et la portabilité.

Étape 1 : proposer des tests unitaires (optionnel)

Notre code comporte un certain nombre de fonctions génériques. On peut vouloir tester leur usage sur des données standardisées, différentes de celles du Titanic.

Même si la notion de tests unitaires prend plus de sens dans un package, nous pouvons proposer dans le projet des exemples d’utilisation de la fonction, ceci peut être pédagogique.

Nous allons utiliser unittest pour effectuer des tests unitaires. Cette approche nécessite quelques notions de programmation orientée objet ou une bonne discussion avec ChatGPT.

Dans le dossier tests/, créer avec l’aide de ChatGPT ou de Copilot un test pour la fonction split_and_count.

- Effectuer le test unitaire en ligne de commande avec

unittest(python -m unittest tests/test_split.py). Corriger le test unitaire en cas d’erreur. - Si le temps le permet, proposer des variantes ou d’autres tests.

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli92

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli9

- 3

- Nettoyer derrière nous

Lorsqu’on effectue des tests unitaires, on cherche généralement à tester le plus de lignes possibles de son code. On parle de taux de couverture (coverage rate) pour désigner la statistique mesurant cela.

Cela peut s’effectuer de la manière suivante avec le package coverage:

terminal

coverage run -m unittest tests/test_create_variable_title.py

coverage report -mName Stmts Miss Cover Missing

-------------------------------------------------------------------

src/features/build_features.py 34 21 38% 35-36, 48-58, 71-74, 85-89, 99-101, 111-113

tests/test_create_variable_title.py 21 1 95% 54

-------------------------------------------------------------------

TOTAL 55 22 60%Le taux de couverture est souvent mis en avant par les gros projets comme indicateur de leur qualité. Il existe d’ailleurs des badges Github dédiés.

Étape 2 : transformer son projet en package (optionnel)

Notre projet est modulaire, ce qui le rend assez simple à transformer en package, en s’inspirant de la structure du cookiecutter adapté, issu de cet ouvrage.

On va créer un package nommé titanicml qui encapsule tout notre code et qui sera appelé par notre script main.py. La structure attendue est la suivante:

Structure visée

ensae-reproductibilite-application

├── docs ┐

│ ├── main.py │

│ └── notebooks │ Package documentation and examples

│ └── titanic.ipynb │

├── configuration ┐ Configuration (pas à partager avec Git)

│ └── config.yaml ┘

├── README.md

├── pyproject.toml ┐

├── requirements.txt │

├── titanicml │

│ ├── __init__.py │ Package source code, metadata

│ ├── data │ and build instructions

│ │ ├── import_data.py │

│ │ └── test_create_variable_title.py │

│ ├── features │

│ │ └── build_features.py │

│ └── models │

│ └── train_evaluate.py ┘

└── tests ┐

└── test_create_variable_title.py ┘ Package testsRappel: structure actuelle

ensae-reproductibilite-application

├── notebooks

│ └── titanic.ipynb

├── configuration

│ └── config.yaml

├── main.py

├── README.md

├── requirements.txt

└── src

├── data

│ ├── import_data.py

│ └── test_create_variable_title.py

├── features

│ └── build_features.py

└── models

└── train_evaluate.pyIl existe plusieurs frameworks pour construire un package. Nous allons privilégier Poetry à Setuptools.

Pour créer la structure minimale d’un package, le plus simple est d’utiliser le cookiecutter adapté, issu de cet ouvrage.

Comme on a déjà une structure très modulaire, on va plutôt recréer cette structure dans notre projet déjà existant. En fait, il ne manque qu’un fichier essentiel, le principal distinguant un projet classique d’un package : pyproject.toml.

terminal

cookiecutter https://github.com/py-pkgs/py-pkgs-cookiecutter.gitDérouler pour voir les choix possibles

author_name [Monty Python]: Daffy Duck

package_name [mypkg]: titanicml

package_short_description []: Impressive Titanic survival analysis

package_version [0.1.0]:

python_version [3.9]:

Select open_source_license:

1 - MIT

2 - Apache License 2.0

3 - GNU General Public License v3.0

4 - Creative Commons Attribution 4.0

5 - BSD 3-Clause

6 - Proprietary

7 - None

Choose from 1, 2, 3, 4, 5, 6 [1]:

Select include_github_actions:

1 - no

2 - ci

3 - ci+cd

Choose from 1, 2, 3 [1]:- Renommer le dossier

titanicmlpour respecter la nouvelle arborescence ; - Créer un fichier

pyproject.tomlsur cette base ;

#| code-summary: "pyproject.toml"

#| filename: "pyproject.toml"

[tool.poetry]

name = "titanicml"

version = "0.0.1"

description = "Awesome Machine Learning project"

authors = ["Daffy Duck <daffy.duck@fauxmail.fr>", "Mickey Mouse"]

license = "MIT"

readme = "README.md"

[build-system]

requires = ["poetry-core"]

build-backend = "poetry.core.masonry.api"

[tool.pytest.ini_options]

log_cli = true

log_cli_level = "WARNING"

log_cli_format = "%(asctime)s [%(levelname)8s] %(message)s (%(filename)s:%(lineno)s)"

log_cli_date_format = "%Y-%m-%d %H:%M:%S"- Créer le dossier

docset mettre les fichiers indiqués dedans - Dans

titanicml/, créer un fichier__init__.py9

#| code-summary: "__init__.py"

#| filename: "__init__.py"

from .data.import_data import (

split_and_count

)

from .pipeline.build_pipeline import (

split_train_test,

create_pipeline

)

from .models.train_evaluate import (

evaluate_model

)

__all__ = [

"split_and_count",

"split_train_test",

"create_pipeline",

"evaluate_model"

]- Installer le package en local avec

pip install -e . - Modifier le contenu de

docs/main.pypour importer les fonctions de notre packagetitanicmlet tester en ligne de commande notre fichiermain.py

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli102

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli10

- 3

- Nettoyer derrière nous

Partie 3 : construction d’un projet portable et reproductible

VSCode actif avec la configuration proposée dans l'application préliminaire, vous pouvez repartir de ce service:

Et ensuite, après avoir clôné le dépôt

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli82

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli8

- 3

- Nettoyer derrière nous

Dans la partie précédente, on a appliqué de manière incrémentale de nombreuses bonnes pratiques vues dans les chapitres Qualité du code et Structure des projets tout au long du cours.

Ce faisant, on s’est déjà considérablement rapprochés d’une possible mise en production : le code est lisible, la structure du projet est normalisée et évolutive, et le code est proprement versionné sur un dépôt GitHub .

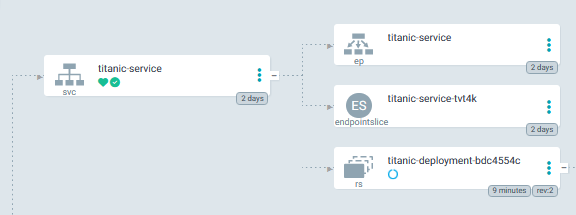

Illustration de l’état actuel du projet

A présent, nous avons une version du projet qui est largement partageable. Du moins en théorie, car la pratique est souvent plus compliquée : il y a fort à parier que si vous essayez d’exécuter votre projet sur un autre environnement (typiquement, votre ordinateur personnel), les choses ne se passent pas du tout comme attendu. Cela signifie qu’en l’état, le projet n’est pas portable : il n’est pas possible, sans modifications coûteuses, de l’exécuter dans un environnement différent de celui dans lequel il a été développé.

Dans cette troisème partie de notre travail vers la mise en production, nous allons voir comment normaliser l’environnement d’exécution afin de produire un projet portable. Autrement dit, nous n’allons plus nous contenter de modularité mais allons rechercher la portabilité. On sera alors tout proche de pouvoir mettre le projet en production.

On progressera dans l’échelle de la reproductibilité de la manière suivante:

- Environnements virtuels ;

- Créer un script shell qui permet, depuis un environnement minimal, de construire l’application de A à Z ;

- Images et conteneurs

Docker.

Nous allons repartir de l’application 8, c’est-à-dire d’un projet modulaire mais qui n’est pas, à strictement parler, un package (objet des applications optionnelles suivantes 9 et 10).

VSCode actif avec la configuration proposée dans l'application préliminaire, vous pouvez repartir de ce service:

Et ensuite, après avoir clôné le dépôt

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli82

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli8

- 3

- Nettoyer derrière nous

Étape 1 : un environnement pour rendre le projet portable

Pour qu’un projet soit portable, il doit remplir deux conditions:

- Ne pas nécessiter de dépendance qui ne soient pas renseignées quelque part ;

- Ne pas proposer des dépendances inutiles, qui ne sont pas utilisées dans le cadre du projet.

Le prochain exercice vise à mettre ceci en oeuvre. Comme expliqué dans le chapitre portabilité, le choix du gestionnaire d’environnement est laissé libre. Il est recommandé de privilégier venv si vous découvrez la problématique de la portabilité.

L’approche la plus légère est l’environnement virtuel. Nous avons en fait implicitement déjà commencé à aller vers cette direction en créant un fichier requirements.txt.

venv

- Exécuter

pip freezeen ligne de commande et observer la (très) longue liste de package - Créer l’environnement virtuel

titanicen s’inspirant de la documentation officielle10 ou du chapitre dédié - Utiliser

lspour observer et comprendre le contenu du dossiertitanic/bininstallé - Le SSPCloud, par défaut, fonctionne sur un environnement

conda. Le désactiver en faisantconda deactivate. - Activer l’environnement et vérifier l’installation de

Pythonmaintenant utilisée par votre machine - Vérifier directement depuis la ligne de commande que

Pythonexécute bien une commande11 avec:

terminal

python -c "print('Hello')"- Faire la même chose mais avec

import pandas as pd - Installer les packages à partir du

requirements.txt. Tester à nouveauimport pandas as pdpour comprendre la différence. - Exécuter

pip freezeet comprendre la différence avec la situation précédente. - Vérifier que le script

main.pyfonctionne bien. Sinon ajouter les packages manquants dans lerequirements.txtet reprendre de manière itérative à partir de la question 7. - Ajouter le dossier

titanic/au.gitignorepour ne pas ajouter ce dossier àGit.

Aide pour la question 4

Après l’activation, vous pouvez vérifier quel python est utilisé de cette manière

terminal

which pythonterminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli11a2

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli11a

- 3

- Nettoyer derrière nous

Les environnements conda sont plus lourds à mettre en oeuvre que les environnements virtuels mais peuvent permettre un contrôle plus formel des dépendances.

conda

- Exécuter

conda env exporten ligne de commande et observer la (très) longue liste de package - Créer un environnement

titanicavecconda create - Activer l’environnement et vérifier l’installation de

Pythonmaintenant utilisée par votre machine - Vérifier directement depuis la ligne de commande que

Pythonexécute bien une commande12 avec:

terminal

python -c "print('Hello')"- Faire la même chose mais avec

import pandas as pd - Installer les packages qu’on avait listé dans le

requirements.txtprécédemment. Ne pas faire unpip install -r requirements.txtafin de privilégierconda install - Exécuter à nouveau

conda env exportet comprendre la différence avec la situation précédente13. - Vérifier que le script

main.pyfonctionne bien. Sinon installer les packages manquants et reprndre de manière itérative à partir de la question 7. - Quand

main.pyfonctionne, faireconda env export > environment.ymlpour figer l’environnement de travail.

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli11b2

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli11b

- 3

- Nettoyer derrière nous

uv est le new kid in the game pour gérer les environnements virtuels avec Python.

venv (via uv)

- Après avoir installé

uv, exécuteruv init .et supprimer le fichierhello.pygénéré. Ouvrir lepyproject.tomlet observer sa structure. - Exécuter

uv pip freezeen ligne de commande et observer la (très) longue liste de package - Créer un environnement virtuel

titanicpar le biais d’uv(documentation) sous le nomtitanic - Utiliser

lspour observer et comprendre le contenu du dossiertitanic/bininstallé - Activer l’environnement et vérifier l’installation de

Pythonmaintenant utilisée par votre machine - Vérifier directement depuis la ligne de commande que

Pythonexécute bien une commande14 avec:

terminal

python -c "print('Hello')"- Faire la même chose mais avec

import pandas as pd. Maintenant, essayeruv run main.pyen ligne de commande: comprenez-vous ce qu’il se passe ? - Installer de manière itérative les packages à partir d’

uv add(documentation) et en testant avecuv run main.py: avez-vous remarqué la vitesse à laquelle cela a été quand vous avez faituv add pandas? - Observer votre

pyproject.toml. Regarder le lockfileuv.lock. Générer automatiquement lerequirements.txten faisantpip compileet regarder celui-ci. - Ajouter le dossier

titanic/au.gitignorepour ne pas ajouter ce dossier àGit.

Aide pour la question 5

Après l’activation, vous pouvez vérifier quel python est utilisé de cette manière

terminal

which pythonterminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli11c2

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli11c

- 3

- Nettoyer derrière nous

Étape 2: construire l’environnement de notre application via un script shell

Les environnements virtuels permettent de mieux spécifier les dépendances de notre projet, mais ne permettent pas de garantir une portabilité optimale. Pour cela, il faut recourir à la technologie des conteneurs. L’idée est de construire une machine, en partant d’une base quasi-vierge, qui permette de construire étape par étape l’environnement nécessaire au bon fonctionnement de notre projet. C’est le principe des conteneurs Docker .

Leur méthode de construction étant un peu difficile à prendre en main au début, nous allons passer par une étape intermédiaire afin de bien comprendre le processus de production.

- Nous allons d’abord créer un script

shell, c’est à dire une suite de commandesLinuxpermettant de construire l’environnement à partir d’une machine vierge ; - Nous transformerons celui-ci en

Dockerfiledans un deuxième temps. C’est l’objet de l’étape suivante.

- Créer un service

ubuntusur le SSP Cloud - Ouvrir un terminal

- Cloner le dépôt

- Se placer dans le dossier du projet avec

cd - Se placer au niveau du checkpoint 11a avec

git checkout appli11a - Via l’explorateur de fichiers, créer le fichier

install.shà la racine du projet avec le contenu suivant:

Script à créer sous le nom install.sh

install.sh

#!/bin/bash

# Install Python

apt-get -y update

apt-get install -y python3-pip python3-venv

# Create empty virtual environment

python3 -m venv titanic

source titanic/bin/activate

# Install project dependencies

pip install -r requirements.txt- Changer les permissions sur le script pour le rendre exécutable

terminal

chmod +x install.sh- Exécuter le script depuis la ligne de commande avec des droits de super-utilisateur (nécessaires pour installer des packages via

apt)

terminal

sudo ./install.sh- Vérifier que le script

main.pyfonctionne correctement dans l’environnement virtuel créé

terminal

source titanic/bin/activate

python3 main.pyterminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli12a2

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli12a

- 3

- Nettoyer derrière nous

- Créer un service

ubuntusur le SSP Cloud - Ouvrir un terminal

- Cloner le dépôt

- Se placer dans le dossier du projet avec

cd - Se placer au niveau du checkpoint 11b avec

git checkout appli11b - Via l’explorateur de fichiers, créer le fichier

install.shà la racine du projet avec le contenu suivant:

Script à créer sous le nom install.sh

install.sh

apt-get -y update && apt-get -y install wget

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh && \

bash Miniconda3-latest-Linux-x86_64.sh -b -p /miniconda && \

rm -f Miniconda3-latest-Linux-x86_64.sh

PATH="/miniconda/bin:${PATH}"

# Create environment

conda create -n titanic pandas PyYAML scikit-learn -c conda-forge

conda activate titanic

PATH="/miniconda/envs/titanic/bin:${PATH}"

python main.py- Changer les permissions sur le script pour le rendre exécutable

terminal

chmod +x install.sh- Exécuter le script depuis la ligne de commande avec des droits de super-utilisateur (nécessaires pour installer des packages via

apt)

terminal

sudo ./install.sh- Vérifier que le script

main.pyfonctionne correctement dans l’environnement virtuel créé

terminal

conda activate titanic

python3 main.pyterminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli12b2

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli12b

- 3

- Nettoyer derrière nous

Étape 3: conteneuriser l’application avec Docker

Cette application nécessite l’accès à une version interactive de Docker. Il n’y a pas beaucoup d’instances en ligne disponibles.

Nous proposons deux solutions:

- Installer

Dockersur sa machine ; - Se rendre sur l’environnement bac à sable Play with Docker

Sinon, elle peut être réalisée en essai-erreur par le biais des services d’intégration continue de Github ou Gitlab . Néanmoins, nous présenterons l’utilisation de ces services plus tard, dans la prochaine partie.

Maintenant qu’on sait que ce script préparatoire fonctionne, on va le transformer en Dockerfile pour anticiper la mise en production. Comme la syntaxe Docker est légèrement différente de la syntaxe Linux classique (voir le chapitre portabilité), il va être nécessaire de changer quelques instructions mais ceci sera très léger.

On va tester le Dockerfile dans un environnement bac à sable pour ensuite pouvoir plus facilement automatiser la construction de l’image Docker.

Docker

Se placer dans un environnement avec Docker, par exemple Play with Docker

Création du Dockerfile

- Dans le terminal

Linux, cloner votre dépôtGithub - Repartir de la dernière version à disposition. Par exemple, si vous avez privilégié l’environnement virtuel

venv, ce sera:

terminal

1git stash

git checkout appli12a- 1

- Pour annuler les modifications depuis le dernier commit

- Créer via la ligne de commande un fichier texte vierge nommé

Dockerfile(la majuscule au début du mot est importante)

Commande pour créer un Dockerfile vierge depuis la ligne de commande

terminal

touch Dockerfile- Ouvrir ce fichier via un éditeur de texte et copier le contenu suivant dedans:

Premier Dockerfile

terminal

FROM ubuntu:22.04

# Install Python

RUN apt-get -y update && \

apt-get install -y python3-pip

# Install project dependencies

COPY requirements.txt .

RUN pip install -r requirements.txt

CMD ["python3", "main.py"]Construire (build) l’image

- Utiliser

docker buildpour créer une image avec le tagmy-python-app

terminal

docker build . -t my-python-app- Vérifier les images dont vous disposez. Vous devriez avoir un résultat proche de celui-ci :

terminal

docker imagesREPOSITORY TAG IMAGE ID CREATED SIZE

my-python-app latest 188957e16594 About a minute ago 879MBTester l’image: découverte du cache

L’étape de build a fonctionné: une image a été construite.

Mais fait-elle effectivement ce que l’on attend d’elle ?

Pour le savoir, il faut passer à l’étape suivante, l’étape de run.

terminal

docker run -it my-python-apppython3: can't open file '/~/titanic/main.py': [Errno 2] No such file or directoryLe message d’erreur est clair : Docker ne sait pas où trouver le fichier main.py. D’ailleurs, il ne connait pas non plus les autres fichiers de notre application qui sont nécessaires pour faire tourner le code, par exemple le dossier src.

- Avant l’étape

CMD, copier les fichiers nécessaires sur l’image afin que l’application dispose de tous les éléments nécessaires pour être en mesure de fonctionner.

Nouveau Dockerfile

terminal

FROM ubuntu:22.04

# Install Python

RUN apt-get -y update && \

apt-get install -y python3-pip

# Install project dependencies

COPY requirements.txt .

RUN pip install -r requirements.txt

COPY main.py .

COPY src ./src

CMD ["python3", "main.py"]Refaire tourner l’étape de

buildRefaire tourner l’étape de

run. A ce stade, la matrice de confusion doit fonctionner 🎉. Vous avez créé votre première application reproductible !

Ici, le cache permet d’économiser beaucoup de temps. Par besoin de refaire tourner toutes les étapes, Docker agit de manière intelligente en faisant tourner uniquement les étapes qui ont changé.

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli132

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli13

- 3

- Nettoyer derrière nous

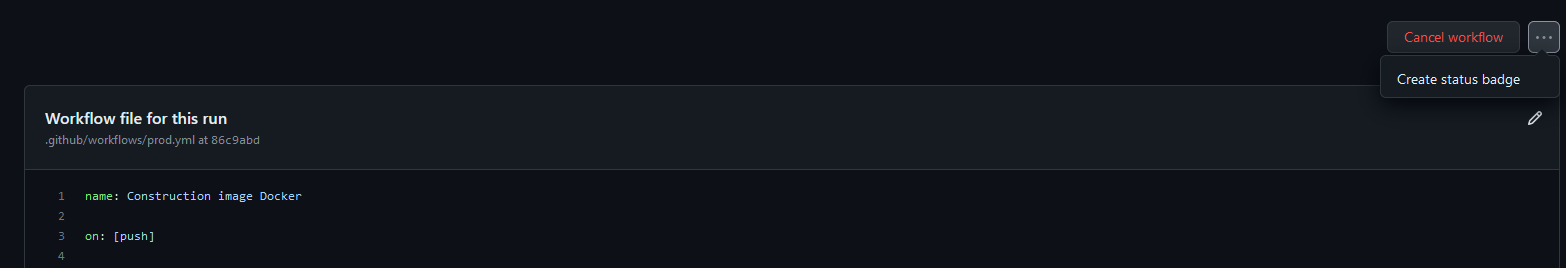

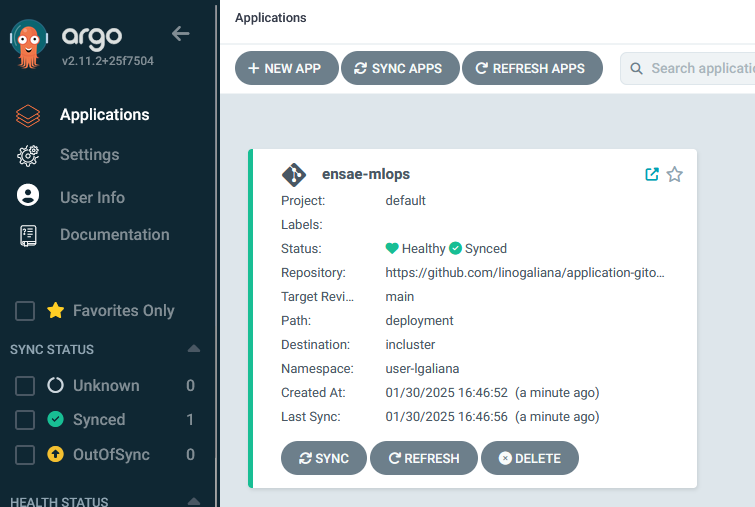

Partie 4 : automatisation avec l’intégration continue

VSCode actif avec la configuration proposée dans l'application préliminaire, vous pouvez repartir de ce service:

Et ensuite, après avoir clôné le dépôt

terminal

curl -sSL https://raw.githubusercontent.com/ensae-reproductibilite/website/refs/heads/main/chapters/applications/overwrite.sh -o update.sh && chmod +x update.sh

./update.sh appli132

rm -f update.sh- 1

- Récupérer le script de checkpoint

- 2

- Avancer à l’état à l’issue de l’application appli13

- 3

- Nettoyer derrière nous

Imaginez que vous êtes au restaurant et qu’on ne vous serve pas le plat mais seulement la recette et que, de plus, on vous demande de préparer le plat chez vous avec les ingrédients dans votre frigo. Vous seriez quelque peu déçu. En revanche, si vous avez goûté au plat, que vous êtes un réel cordon bleu et qu’on vous donne la recette pour refaire ce plat ultérieurement, peut-être que vous appréciriez plus.

Cette analogie illustre l’enjeu de définir le public cible et ses attentes afin de fournir un livrable adapté. Une image Docker est un livrable qui n’est pas forcément intéressant pour tous les publics. Certains préféreront avoir un plat bien préparé qu’une recette ; certains apprécieront avoir une image Docker mais d’autres ne seront pas en mesure de construire celle-ci ou ne sauront pas la faire fonctionner. Une image Docker est plus souvent un moyen pour faciliter la mise en service d’une production qu’une fin en soi.

Nous allons donc proposer plusieurs types de livrables plus classiques par la suite. Ceux-ci correspondront mieux aux attendus des publics utilisateurs de services construits à partir de techniques de data science. Docker est néanmoins un passage obligé car l’ensemble des types de livrables que nous allons explorer reposent sur la standardisation permise par les conteneurs.